Meglepetés: A Facebook azt mondja, hogy a Facebook rendben van a hírekért!

Az egyetlen probléma? Ez egy Facebook-tanulmány, amelyet a Facebook alkalmazásában álló emberek végeztek.

Valóban csodálkoznunk kell azon, hogy a Facebook saját kutatói minimalizálják a vállalatuk által az emberek hírcsatornáival végzett manipulációk hatását?

A tanulmány, Ideológiailag sokféle hír és vélemény a Facebookon, Eytan Bakshy és a Facebook munkatársai a múlt héten tették közzé Tudomány. Hogyan lehet ezt a tanulmányt megjelentetni a rangos folyóiratban Tudomány? 1 Nem a szakértői értékelésnek kell-e feltárnia olyan öncélú tanulmányokat, amelyeket olyan vállalatok tettek közzé, amelyek csak azt mutatják be, hogy a vállalat mit akar az adatok megmutatni?

El kell gondolkodni azon, hogy a szakértői véleményezők miként teljesítették ezt a tanulmányt, közzétéve. A tanulmány számos kritikája már megjelent, ezért csak gyorsan összefoglalom a mások által idézett problémákat. Christian Sandvig kritikája nagyjából összefoglalja azt a problémát, hogy a Facebook kutatói hogyan pörgették meg saját eredményeiket a közzétett tanulmányban:

Az összehasonlítások kapcsán a tanulmány a következőket mondja:

„Meggyőzően megállapítjuk, hogy ... az algoritmusoknál nagyobb egyéni választások korlátozzák az attitűd-kihívást jelentő tartalom kitettségét.”

"Az algoritmikus rangsoroláshoz képest az egyének fogyasztási döntéseinek erősebb hatása volt"

Vészharangok szólnak nekem. A dohányipar egyszer finanszírozhatott egy tanulmányt, amely szerint a dohányzás kevésbé veszélyes, mint a szénbányászat, de itt van egy tanulmányunk a szénbányászokról a dohányzásról. Valószínűleg, amíg a szénbányában vannak.

Azt akarom mondani, hogy nincs olyan forgatókönyv, amelyben a „felhasználói választások” és az „algoritmus” eladhatók lennének, mivel ezek együttesen történnek […]. A felhasználók abból válogathatnak, amit az algoritmus már szűrt nekik. Ez egy szekvencia.

Úgy gondolom, hogy e két dolog helyes kijelentése az, hogy mindkettő rossz - mindkettő növeli a polarizációt és a szelektivitást. Mint fentebb említettem, úgy tűnik, hogy az algoritmus szerényen növeli a felhasználók szelektivitását.

Valójában azt gondolná, hogy a Facebook kutatói, akik tudják, hogy a Facebookon dolgoznak, megértenék, hogy nem lehet ugratni és elkülöníteni az algoritmust a felhasználó viselkedésétől, mivel az egyik függ a másiktól. Az algoritmus manipulálása nélkül (amelyet Adam Kramer által felfedezett Facebook-kutatás nem jó dolog a felhasználó tájékozott beleegyezésének megszerzése nélkül), nem igazán lehet megmondani, miért kattintanak a felhasználók egy dologra többet, mint valami mást.

De Zeynep Tufekci, a Chapel Hill észak-karolinai egyetem professzorának Facebook-tanulmányának ez az áttekintése azt írta, hogy amit a tanulmány adatai valóban találtak, azt a tanulmány mellékletében temették el:

Minél magasabb a link, annál (sokkal több) valószínű, hogy rákattintanak. A hírcsatorna-algoritmus által meghatározott elhelyezés alapján élsz és halsz meg. (A hatás, ahogy Sean J. Taylor helyesen megjegyzi, az elhelyezés és az a tény, hogy az algoritmus kitalálja, mit szeretne.

Ez már többnyire ismert volt, de nagyon jó, hogy a Facebook kutatói megerősítették (a tanulmányt kizárólag a Facebook munkatársai írták). […]

Az egyik új megállapítás az, hogy a hírcsatorna-algoritmus (szerényen) elnyomja a különféle tartalmakat, egy másik kulcsfontosságú és újszerű megállapítás az, hogy a hírcsatornába helyezés (erősen) befolyásolja az átkattintási arányokat.

A Facebook olyan híreket mutat be, amelyeket nagyobb valószínűséggel olvas el (mert egyezik a politikai nézőpontoddal), és hogy minél magasabbra jelenik meg a hírcsatornádban, annál valószínűbb, hogy rákattintasz.

Más szavakkal, a Facebook által végzett hírcsatorna-manipuláció továbbra is fontos hozzájáruló tényező annak meghatározásában, hogy mire fog valószínűleg kattintani. És továbbra is manipulálják ezt a hírcsatornát, hogy politikailag igazodó híreket mutassanak neked jobban, mintha algoritmusukban semmiféle elfogultság nem lenne.

És - amint Tufekci fontos megjegyzi - ez egy apró, válogatott Facebook-felhasználók csoportja volt, amelyet tanulmányoztak, csak azért, mert a Facebook kutatóinak kényelmesebb (és olcsóbb) volt őket tanulmányozni. Csak azokat a felhasználókat nézték meg, akik önállóan azonosították politikai hovatartozásukat a Facebook-on, és rendszeresen bejelentkeztek a szolgáltatásba (az összes Facebook-felhasználó körülbelül 4 százaléka [a felhasználóknak csak 9 százaléka nyilatkozik politikai hovatartozásáról a Facebook-on, vagyis ez nem egy általánosítási minta) bármit is]). Nem mond semmit azokról a Facebook-felhasználókról, akik nem jelentik be politikai hovatartozásukat a Facebookon - ami a legtöbbünk.

Végezhetett volna egy erőteljesebb tanulmányt a Facebook? Persze, de ehhez hagyományosabb kutatási technikákra lett volna szükség, például felmérés toborzásra a helyszínen, véletlenszerű e-mail toborzással kombinálva.

Tehát itt van az a szűretlen, elfogulatlan megállapítás az adatokból (Tufekci jóvoltából), amelyet a Facebook kutatói látszólag megpördítettek, mondván, hogy nem az ő hibájuk az, amit a hírcsatornájukban lát.

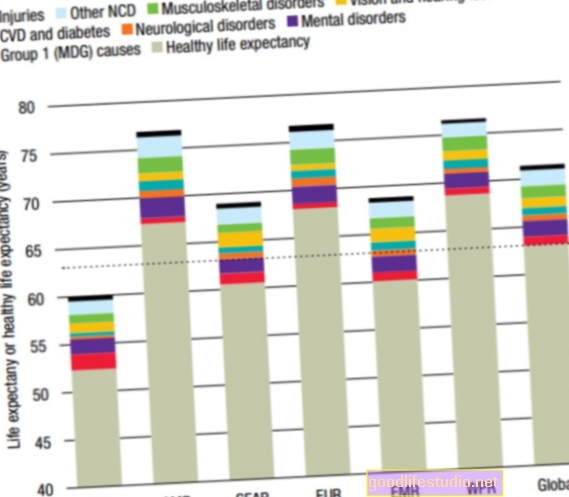

A Facebook kutatói meggyőzően mutatják, hogy a Facebook hírcsatorna-algoritmusa mérhető mértékben csökkenti az ideológiailag sokszínű, átfogó tartalmat, amelyet az emberek a közösségi hálózataikon látnak a Facebookon. A kutatók arról számolnak be, hogy a különféle tartalmaknak való kitettséget a Facebook algoritmusa 8% -kal elnyomja az önálló liberálisok és 5% az önállóan azonosított konzervatívok esetében.

Vagy, ahogy Christian Sandvig fogalmaz, „az algoritmus kiszűri 20 olyan átfogó, nehéz hírből 20-at, amelyet egy önmagát azonosító konzervatív lát (vagy 5%), és 13-ból 1 olyan átfogó, kemény hírből, amelyet egy önálló liberális lát (8%). ” Kevesebb olyan hír jelenik meg, amelyekkel nem értene egyet, és amelyeket ismerősei megosztanak, mert az algoritmus nem mutatja meg azokat.

Sajnos a New York Times és néhány további értékesítési lehetőség, a legtöbb mainstream médiaoldal éppen szkepticizmus nélkül számolt be arról, amit a Facebook kutatói állítottak tanulmányukban.

De most már tudja az igazságot - a Facebook egy kicsi, nem reprezentatív mintát tanulmányozott, majd lebecsülte azt, amit adatai valóban megmutattak, hogy hangsúlyozzák a vállalat szempontjából pozitívabb eredményt. Számomra ez egy újabb példa arra, hogy a Facebook kutatói nem igazán értik a tudományos kutatás lényegét - olyan tudást osztanak meg a világgal, amely nem elfogult és manipulált.

További olvasmányok…

Zeynep Tufekci: Hogyan a Facebook algoritmusa elnyomja a tartalom sokszínűségét (szerényen) és hogyan szabályozza a hírcsatorna a kattintásait

Christian Sandvig: A Facebook „Nem a mi hibánk” tanulmány

NY Times: Facebook használja a polarizálást? A webhely különbözik

Lábjegyzetek:

- Sajnos most hozzá kell adnom egy újabb folyóiratot az elismert tudományos publikációk listájához, amelyek további vizsgálatot igényelnek. Mint a Pszichológia Világának régóta olvasói tudják, ez a lista minden évben hosszabb lesz: Gyermekgyógyászat (A gyermekgyógyászat tanulmányokat tesz közzé a technológiáról, amelyeket nyilvánvalóan senki sem tekint át az alapkutatás okozati összefüggéseinek ismeretében.), Kiberpszichológia, viselkedés és szociális hálózatok (A kiberpszichológia nyilvánvalóan bármilyen tanulmányt publikál az internetes függőségről vagy a közösségi hálózatokról, azok minőségétől függetlenül.) És most, Tudomány. [↩]